人工知能というか正確に言えば更に発展したディープラーニングを使った画像補完技術が予想を上回るレベルになっています。

画像レタッチ?いやレタッチでも画像補正でもなく無から有を作り出す補完技術技術です。

畳み込みニューラルネットワークという技術を使っているようで、知り合いのプログラマーに畳み込みニューラルネットワークとはなんぞや?と聞いてみたのですが、聞いてもよく分かりませんでした^^;

とにかくディープラーニングの世界では囲碁や将棋だけでなく画像に関しての技術も凄いことになっています。

早稲田大学の飯塚里志助教の研究チームが開発した画像補完技術「Globally and Locally Consistent Image Completion」をご紹介します。

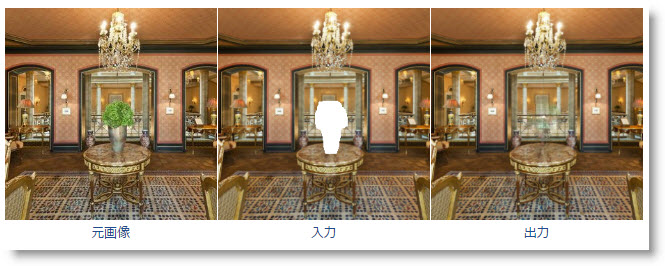

以下のキャプチャー画像を御覧ください。

元画像の中心部分を削除してデータ入力。画像は削除された部分を見事に補完して出力されています。

もちろん予測の補完データですので元画像と同じになる訳ではないのですが、違和感を感じさせない出力データになっています。

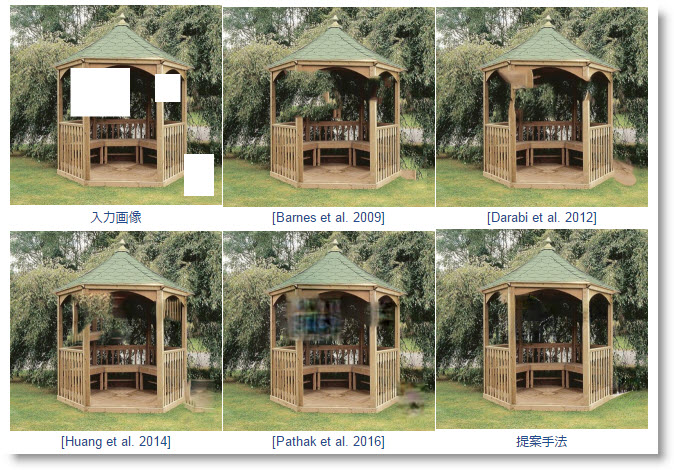

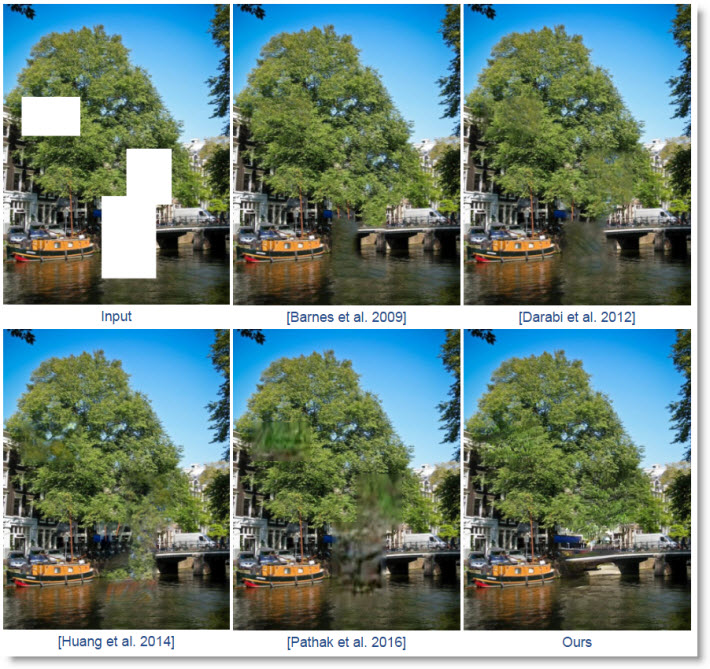

以下の数年前の補完技術と比べると一目瞭然です。

下の画像の左上が一部分を削除した入力画像。

2009年、2012年、2014年、2016年時点での画像補完ソフトでは違和感のある出力画像になっていることがわかります。

対して右下の新技術による出力画像は今までの技術とはまったくレベルが違うことが良くわかります。

一見簡単そうに見える木の欠如部分でも現状の技術はレベル差を感じます。

橋の欠如部分の補完に関しては圧倒的なレベル差です。

飯塚里志さんがTwitter上で動画をアップしてくれていますので、そちらを見ると更に凄さが分かります。

SIGGRAPH 2017に論文が正式に採択されました。ディープラーニングによって複雑な画像補完を行う手法です。画像中の不要な物体を消したり、人の顔を変化させたりもできます。https://t.co/iHccQXmqEh pic.twitter.com/zhmVjIajcy

— Satoshi Iizuka (@stsiizk) 2017年4月30日

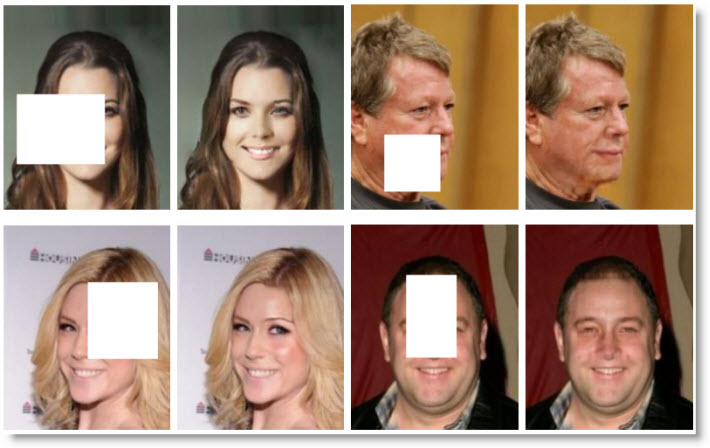

動画を見ると分かりますが、この技術を使うと人の顔まで予測反映させることが可能。

飯塚さんが非常に面白い実験をしてくれています。以下のTwitterです。

リクエストが多かったタモリさんのサングラス除去。失敗? pic.twitter.com/pTWwAlf14f

— Satoshi Iizuka (@stsiizk) 2017年4月30日

まさかのタモさんで実験するとは。

サングラスからの予測だとさすがに実際の顔に近づけるのは難しいかもしれませんが顔の一部分であれば以下のように比較的違和感なく補完出来るようです。

これは驚き。

こういった技術がPhotoshopやスマートフォンアプリに搭載されるようになる日は近いのかもしれません。

もう写真が加工されたものかどうかを見極めるのは本当に難しい時代に入りましたね。

フランスでレタッチした写真にはレタッチしたことを明記しなくはならない法律が出来るのも理解できます。

ディープランニングなどに詳しい方やこの技術について興味のある方は以下のサイトを御覧ください。

多くのテストデータを見ることが出来ます。

コメント

コメント一覧 (2件)

SECRET: 0

PASS: 74be16979710d4c4e7c6647856088456

ランニングではなくラーニング(学習)です

SECRET: 0

PASS: 74be16979710d4c4e7c6647856088456

ご指摘ありがとうございます!

三カ所中二カ所もランニングになってました(>人<;)